Volume 19, No. 3, Art. 34 – September 2018

Praxis und Theorie des Theoretical Sampling. Methodologische Überlegungen zum Verfahren einer verlaufsorientierten Fallauswahl

Oliver Dimbath, Michael Ernst-Heidenreich & Matthias Roche

Zusammenfassung: Theoretical Sampling ist als Methode der Fallauswahl ein in der qualitativen Forschung etablierter Gegenentwurf zur repräsentativen Zufallsstichprobe. Im Zentrum steht die Verzahnung des Auswertungsprozesses mit der Auswahl der zu untersuchenden Fälle beziehungsweise Untersuchungseinheiten. In diesem Beitrag diskutieren wir vorliegende Verfahrensvorschläge, identifizieren Schwächen in der Reflexion und Darstellung bei der Auswahl forschungsrelevanter Untersuchungseinheiten und schlagen eine an das Memoing angelehnte Dokumentationsform vor. Zur Illustration dient ein Forschungsprojekt, anhand dessen Wege zur Präzisierung und Systematisierung der Fallauswahl mithilfe sogenannter Verlaufskarten aufgezeigt werden sollen.

Keywords: qualitative Methoden; Fallauswahl; Grounded-Theory-Methodologie; Theoretical Sampling; Verlaufskarte

Inhaltsverzeichnis

1. Einleitung

2. Die Fallauswahl in explorativ-qualitativen Forschungsdesigns

2.1 Der Ursprung des Theoretical Sampling

2.2 Weiterentwicklungen des Theoretical Sampling

3. Die Fallauswahl als theoriekonstitutive Entscheidungskette

3.1 Illustrationen: Stadtteilforschung im Augsburger Universitätsviertel

3.2 Entscheidungskriterien bei der Fallauswahl

3.3 Verlaufskarten als Reflexions- und Dokumentationsinstrument

4. Diskussion

5. Schluss und Ausblick

Theoretical Sampling ist ein im Kontext der Grounded-Theory-Methodologie (GTM) etabliertes Verfahren der Fallauswahl.1) Eingeführt wurde es als Gegenmodell zur repräsentativen Zufallsstichprobe beziehungsweise einer a priori festgelegten, merkmalsvermittelten und heuristisch dimensionierten Fallauswahl (vgl. z.B. COYNE 1997). Im Gegensatz zu solchen Strategien erfolgt die Auswahl der Fälle beim Theoretical Sampling im Wechselspiel mit der Auswertung und Interpretation bereits generierter Forschungsdaten. [1]

In unserem Beitrag problematisieren wir den Stand der Debatte zum Theoretical Sampling dahingehend, dass es in unseren Augen von wenigen Ausnahmen (z.B. TRUSCHKAT, KAISER-BELZ & VOLKMANN 2011) abgesehen, bisher nicht gelungen ist, das Verfahren im Hinblick auf seine Praktikabilität und Transparenz angemessen darzustellen. Daher werden wir im ersten Schritt unserer Überlegungen die Entstehung und Entwicklung des Theoretical Sampling im Kontext qualitativer Sozialforschung im Allgemeinen und der GTM im Besonderen referieren. Auf diesem Weg werden Stärken des Theoretical Sampling, aber auch verfahrensseitige Schwächen deutlich. Vor dem Hintergrund unserer eigenen Forschungserfahrung diskutieren wir anschließend die Fallselektion als Entscheidungskette, die sich aus komplexen Vergleichsoperationen und Abgleichen mit dem Vorwissen der Forschenden ergibt.2) Um solche Vergleiche zu systematisieren, haben wir das Instrument der Verlaufskarte entwickelt, das wir in der Folge vorstellen. Mithilfe von Verlaufskarten können Selektionsentscheidungen von der Konzeptentwicklung bis hin zur theoretischen "Sättigung" dokumentiert und bei der Theoriekonstruktion verwertet werden. Ein (Lehr-) Forschungsprojekt aus der Stadtteilforschung dient der Illustration. [2]

Ziel unserer Ausführungen ist es, der Fachdebatte über Fallauswahlstrategien in der qualitativen Sozialforschung einen konstruktiven Diskussionsimpuls zur Praktikabilität und Transparenz von Fallauswahlentscheidungen per Theoretical Sampling zu geben. Damit bieten wir erstens ein Hilfsmittel zur Reflexion von Fallauswahlentscheidungen, zweitens ein Dokumentationstool, das die Fallauswahl für die spätere Berichtlegung fruchtbar macht und drittens ein Verfahren, um Güte- und Legitimationsansprüchen gerecht zu werden an.3) [3]

2. Die Fallauswahl in explorativ-qualitativen Forschungsdesigns

Die Zusammensetzung des Datenkorpus ist ein dokumentationsrelevanter Aspekt empirischer Forschung. Informationen zur Fallselektion sind entscheidend, um die Reichweite der Ergebnisse, das heißt ihre Verallgemeinerbarkeit und Güte abzuschätzen. Beim Theoretical Sampling sind Fallauswahlentscheidungen entlang des bereits vollzogenen Forschungsprozesses und der parallel erfolgenden Konzeptbildung zu begründen. In der Praxis wird nur selten eine umfassende Reflexion und transparente Darstellung der für die Erkenntnisgewinnung relevanten Entscheidungsmomente erreicht.4) Bevor wir auf den aktuellen Debattenstand zu diesem Fallauswahlverfahren eingehen, skizzieren wir einige Wegmarken der Entstehung des Theoretical Sampling. [4]

2.1 Der Ursprung des Theoretical Sampling

Mit der Entwicklung und Verbreitung qualitativer Methoden, denen es nicht um statistische Repräsentativität geht, sondern um eine "Repräsentativität der Konzepte" (MUCKEL 2011, S.337), mussten neue Wege der Fallauswahl erschlossen werden. Das Theoretical Sampling gilt als ein den Erfordernissen ergebnisoffener, explorierender Forschung angemessenes Verfahren. Damit erscheint es als Gegenmodell zu einer ex ante durch theoretische Vorannahmen selektierten sowie numerische Repräsentativität anstrebenden Stichprobenziehung (GLASER & STRAUSS 1967, 1970).5) [5]

Der grundlegende Unterschied besteht darin, die Fallauswahl und die Datenerhebung mit der Datenauswertung zu verzahnen. Ziel ist die Initiierung eines Erkenntnisprozesses, in dem sich die fortschreitende Entwicklung theoretischer Einsichten umsetzen und abbilden lässt. STRÜBING (2011, S.271) spricht in diesem Zusammenhang von einem "inkrementellen" Vorgehen, LINDEMANN (2008, S.108) von einer Strategie des "Häppchen-Falsifikationismus". Forscher(innen) nähern sich ihrem Forschungsfeld mit eher allgemeinen oder heuristischen Vermutungen.6) Durch die Prüfung dieses Vorverständnisses an den im Feld generierten Daten werden auf Dauer robuste Konzepte mit empirischem Gehalt entwickelt. Die Theorieentwicklung wird in der GTM als verschachtelter Kodierprozess beschrieben,7) wobei die Kodierarbeit in die Entwicklung zentraler, den Forschungsgegenstand charakterisierender Kategorien mündet. Dies erfolgt, indem relevante Daten im Analyseprozess mit möglichst prägnanten Begriffen (Kodes) belegt werden, die dann zu Überbegriffen oder Kategorien zusammengefasst bzw. voneinander abgegrenzt werden können (vgl. hierzu ausführlich MUCKEL 2011, S.338f.). Während der theoretisch-konzeptionellen Arbeit sehen sich Forschende permanent mit der Frage konfrontiert, warum welche Untersuchungseinheit als nächste fokussiert werden soll. Jede weitere Fallauswahl soll dabei helfen, das Kategoriengerüst beziehungsweise das theoretische Verständnis des Gegenstandsbereichs zu irritieren und dadurch weiterzuentwickeln. [6]

Da die Entwicklung und Verfeinerung von Kategorien im Mittelpunkt stehen, ist es irrelevant, ob die Daten formal vergleichbar sind8). Im Gegenteil sind – in Übereinstimmung mit dem von GLASER (2001) formulierten Diktum "all is data" – gerade die Vielfalt und der Facettenreichtum der verfügbaren Daten eine Bereicherung. Es hängt von Forschungsgegenstand und Forschungsprozess ab, ob Beobachtungsprotokolle, Dokumente, Interviews, Umfrageergebnisse, Strukturinformationen oder anderweitige Daten in die Analyse einbezogen werden. Voraussetzung bleibt jedoch, dass die Interpretation des Datenmaterials beim theoretischen Verständnis beziehungsweise der Vorstellungskraft der oder des Forschenden beginnt. [7]

Die Effektivität des sukzessiven, die Interpretationsbefunde unterschiedlicher Daten ver- und abgleichenden Vorgehens zeigt sich in einem sich permanent verbessernden Verständnis des Forschungsgegenstands. Das Verfahren ist effizient, da nur Daten generiert werden, die dabei helfen, die Charakterisierung des Forschungsgegenstands weiter zu präzisieren.9) Diese Arbeit an der Theorie oder Konzeptualisierung (GLASER 2002; GLASER & STRAUSS 1967) zielt darauf, zentrale Aspekte und Eigenschaften kategorial zu benennen und in Daten gründende Vermutungen über ihr Zusammenwirken zu erhärten beziehungsweise anzupassen oder zu verwerfen. Die selektive Datenerhebung und gegenstandsbezogene Auswertung endet, sobald die zentralen Kategorien gesättigt sind. Von Sättigung einer Kategorie sprechen GLASER und STRAUSS (1967), wenn die Generierung weiterer Daten und deren Analyse nicht länger Erträge für die Ausarbeitung der zentralen Kategorie(n) erbringt.10) Weiterhin gehen GLASER und STRAUSS (1970) davon aus, dass Forscher(innen) im Fortgang der Theorieentwicklung erkennen,11) welche Kategorien weiter angereichert werden können und welche sich als verzichtbar erweisen:

"All categories are obviously not equally relevant, and so the depth of inquiry into each one should not be the same. (...) As this theory develops and becomes integrated, the sociologist learns, which categories require the most and least complete saturation, and which ones can be dropped" (S.113). [8]

In der Praxis müssen grundlegende Entscheidungen abseits der schrittweisen Verfeinerung einer Kategorie gefällt werden. Die Frage, ob einerseits nach weiteren Kategorien zu suchen und/oder andererseits an bestehenden Kategorien unterschiedlichen Sättigungsgrades weiterzuarbeiten ist, sollte nicht "forschungspragmatisch" mit Verweis auf die Engführungen der anfänglichen Fragestellung vorschnell beantwortet werden. Denn eine zu starke Fokussierung der Forschungsarbeit kann zu ungerechtfertigten Ausschlüssen möglicherweise relevanter Aspekte und damit zur Bildung einer dünnen und unausgewogenen Theorie führen. Theoretical Sampling fordert im Grunde bei jeder Fallauswahlentscheidung eine Reflexion darüber, was genau die Aufmerksamkeit der Forschenden gelenkt hat. Diese doppelte Selbstvergewisserung über den Grad der Sättigung auf der einen und noch nicht begangene Pfade auf der anderen Seite sollte nicht nur Bestandteil der Dokumentation sein, sondern dazu beitragen, die Theoriebildung zu konsolidieren.12) [9]

2.2 Weiterentwicklungen des Theoretical Sampling

Beiträge zum Theoretical Sampling sind oft zurückhaltend, wenn es um Berichte zur konkreten Umsetzung oder um die Entwicklung von Formvarianten geht. Eher scheinen sie dazu anzuleiten, ein erfahrungsbezogenes Gespür der Forschenden für Selektionsentscheidungen und damit ein professionsbezogenes Routinewissen auszubilden. Dies sei eine grundlegende Fähigkeit oder sogar Kunst, welche für die Anwendung der Methode von großer Bedeutung sei. Zwar kann kaum bezweifelt werden, dass erfahrene Forscher(innen), die über exzellente Forschungsfertigkeiten ("excellent research skills", MORSE 2007, S.230) verfügen, mit größerer Wahrscheinlichkeit erfolgreich forschen werden. Aus methodischer Sicht kann die Betonung der Exzellenz nicht befriedigen. Der Verweis auf die Bedeutung der Urteilskraft ("judgement", HAMMERSLEY 2006, S.298) von Forschenden beim Theoretical Sampling ist – insbesondere beim Einstieg in ein Forschungsfeld – von begrenztem Nutzen. Wenig hilfreich ist auch der Hinweis auf die von den Forschenden aufzubringende "theoretische Sensibilität", wird hier doch auf eine Fähigkeit Bezug genommen, die bereits vorhanden sein muss. Insgesamt bleibt die Orientierung abseits des Aufrufs zu prinzipieller Offenheit oft unbestimmt,13) indem teilweise auf umfassende Kenntnis einschlägiger Forschungsliteratur und Felderfahrung, teilweise auf das grundlagenbezogene "Handwerkszeug" etablierter Theorien abgehoben wird. Besonders gravierend ist diese Unterbestimmtheit bei der Fallauswahl. So finden sich kaum Positionen, die auch und vor allem beim Beginn der Datensammlung eine Diskussion über Art und Umfang der Referenzpunkte theoretischer Vorannahmen als eigenständige Phase im Forschungsprozess fordern. Nur beiläufig kommt die Reflexion von Vorannahmen im Allgemeinen oder die Entwicklung einer Sensibilität dafür zur Sprache, welche dieser Annahmen im Forschungsprozess erkenntnisleitend werden sollen oder geworden sind.14) Folgt man dieser Perspektive, werden nicht die Noviz(inn)en der empirischen Feldarbeit zum Problem, sondern die erfahrenen Praktiker(innen), welche die zu treffenden, umfänglichen Entscheidungen gar nicht mehr zu reflektieren vermeinen müssen. Geht man aber davon aus, dass die Entscheidungen bei der Fallauswahl ebenso wie bei der Interpretation des Datenmaterials aus Gründen der Nachvollziehbarkeit reflexionsbedürftig und obendrein ihrerseits typisierbar, kategorisierbar und damit systematisierbar sind, können forschungspraktische Konsequenzen gezogen werden: Erstens liegt es nahe, die Grundlagen der einzelnen Schritte der Datengenerierung und damit verbundener Interpretationsentscheidungen möglichst genau zu reflektieren und zu dokumentieren. Zweitens empfiehlt sich eine fortlaufende Bilanzierung dieser Entscheidungsgrundlagen auch in Bezug auf den Fortgang der Deutungsarbeit und der Theorieentwicklung. Anhaltspunkte für eine solche Systematisierung finden sich nur sporadisch im Schrifttum zur GTM.15) Im Folgenden wird kurz auf entsprechende Hinweise eingegangen. [10]

Die älteste Spielart der sukzessiven Fallauswahl geht auf die Zusammenarbeit von GLASER und STRAUSS zurück. Permanentes Vergleichen ermöglicht eine "simultaneous maximimization or minimization of both the differences and the similarities of data that bear on the categories being studied" (1967, S.55). Die Doppelstrategie des Vergleichens auf Grundlage maximaler und minimaler Kontrastierung hat Folgen für den Auswertungsprozess, aber auch für weitere Fallauswahlentscheidungen. Die jeweils nächste Iteration der Datenerhebung kann so ausgerichtet werden, dass eine bestehende Kategorie in ihrer konzeptionellen Reichweite profiliert oder weiter präzisiert wird. Bei maximaler Kontrastierung richtet sich die Suche somit auf forschungsrelevante Fälle, die sich gemäß ihrer Strukturmomente stark vom bisher Analysierten und den im Zuge des Kodierens identifizierten Kategorien unterscheiden. Ziele sind dabei das Auffinden der konzeptuell relevanten Heterogenität des Forschungsgegenstands sowie eine potenzielle Irritation bisheriger Konzepte und Kategorien. Die minimale Kontrastierung sucht demgegenüber strukturell ähnliche Vergleichsfälle mit dem Ziel, eine Kategorie durch die Integration von erkennbar zusammenhängenden Variationen zu präzisieren. Dies erfolgt über eine Ausweitung der Binnendifferenzierung (GLASER 1965; KELLE & KLUGE 2010; STRÜBING 2008). [11]

Ein weiterführender Vorschlag zur Fallauswahl wird von STRAUSS und CORBIN (1998 [1990], S.206ff.) unterbreitet. Dieser besteht in einer Fallselektion mit unterschiedlicher Körnung, welche an die deren Grundtypen des Kodierens (offenes, axiales und selektives Kodieren) angelehnt ist. Dementsprechend identifizieren sie Strategien der offenen ("open sampling"), der relationalen ("relational sampling") und selektiven ("discriminate sampling") Fallauswahl. Bei einem derart offenen beziehungsweise optionalen Verfahren erscheint es nur konsequent, dass STRAUSS und CORBIN neben der Orientierung an bisherigen Kodierergebnissen auch ein deduktives Vorgehen für möglich erachten. Die Vorstellung, konzeptionelle Ideen per Sampling testen zu können, ist bei GLASER auf massive Kritik gestoßen, der hier einen grundlegenden Widerspruch zum Anspruch der GTM zu erkennen glaubt, Konzepte nicht den Daten aufzuzwingen, sondern dafür aufmerksam zu sein, "what is emerging in the data as the theory is generated" (1992, S.103; vgl. die Diskussion bei TRUSCHKAT et al. 2011, S.369f.). [12]

Aus dem Kontext unserer eigenen empirisch-praktischen Forschung erscheint der Einwand gewichtiger, dass kein eindeutiger Modus für eine intersubjektiv nachvollziehbare, reflektierbare und kritisierbare Darstellung von Entscheidungsprozessen vorgesehen ist. Man mag diese methodische Unbestimmtheit als Stärke der GTM begreifen, gleichwohl finden mit den vielen Teilentscheidungen immer auch Pfadsetzungen statt, die als Pfadabhängigkeiten auch von einem disziplinierten Memoing in der Regel nicht erfasst werden. Zwischen den Extremen eines sich selbst perpetuierenden und zugleich hochgradig reflexionsbedürftigen "Audit Trails"16) der unerfahrenen Forscher(innen) und der routinierten Sensibilität der Meister(innen) sollten erhebliche Unterschiede der Prozesssteuerung und -begründung bestehen. Diese Unterschiede könnten durch die Einführung von (Güte-) Kriterien für den Verlauf sukzessiver Auswahlentscheidungen besser reflektiert werden. Die epistemologische Stärke des Theoretical Sampling droht sonst zur Chiffre für einen nicht näher zu spezifizierenden, irgendwie sinnhaften Verlauf der interpretativen Gegenstandserschließung zu werden. Entscheidungen der schrittweisen Gewinnung von Untersuchungseinheiten bedürfen einer eigenen, auf die Forschungssituation abgestimmten Reflexion17) oder, falls dies z.B. schon implizit durch Memoing gewährleistet sein sollte, einer expliziten Behandlung. [13]

3. Die Fallauswahl als theoriekonstitutive Entscheidungskette

Die Diskussion von Fallauswahlentscheidungen im Kontext des Theoretical Sampling lässt sich am besten unter Bezug auf konkrete Daten nachvollziehen. Im Weiteren illustrieren wir die Vorgehensweise anhand authentischer Entscheidungssituationen in einem Lehrforschungsprojekt. Als Beispiel dient eine Studie zum Leben und Arbeiten in einem Augsburger Stadtteil. [14]

3.1 Illustrationen: Stadtteilforschung im Augsburger Universitätsviertel

Die Entscheidung für eine explorative Analyse des Augsburger Universitätsviertels ergab sich infolge eines Impulses durch einen Mitarbeiter einer Kirchengemeinde im Viertel. Ihm war die vermeintlich hohe "Anonymität" innerhalb des Quartiers aufgefallen, woraufhin er das Gespräch mit Soziolog(inn)en der benachbarten Universität suchte. In Ermangelung finanzieller Ressourcen kam man überein, dem Interesse an den Besonderheiten der Strukturierung dieses Lebensraumes im Rahmen eines Lehrforschungsprojekts der qualitativen Methodenausbildung nachzugehen. Ausgangspunkt der Forschungsbemühungen war die Frage, wie das Universitätsviertel entlang der dort vorzufindenden Arbeits- und Lebensbedingungen beschrieben werden kann. [15]

Die Forschungsarbeit war durch einige Spezifika gekennzeichnet: Erstens gab es keine Verpflichtungen gegenüber einem Auftrag- oder Mittelgeber und damit keine "harte" Begrenzung der Projektlaufzeit. Im Grunde war es möglich, so lange zu forschen, bis die Forschenden eine angemessene Antwort gefunden hatten. Dieser Luxus an Zeitressourcen ermöglichte es, das Augenmerk auf Probleme zu richten, die im Forschungsalltag schnell unter den Tisch fallen können – zum Beispiel die ausführliche Reflexion jedes einzelnen Schrittes in der Datenerhebung. Der Feldzugang war zweitens zunächst logistisch unproblematisch,18) da die Universität am Rand des Universitätsviertels liegt und keine Felderschließungs- oder Reisekosten gewärtigt werden mussten. Drittens ermöglichte es die Form des universitären Seminars, mit der sehr komfortablen Teamgröße von 20 Studierenden sowie drei Dozenten zu arbeiten und zugleich mehrere Verfahren der qualitativen Datengenerierung parallel einzusetzen. Zugleich waren mit diesen Spezifika auch Schwierigkeiten beziehungsweise Restriktionen verbunden. Einerseits wurde aufgrund der großen Anzahl von Forscher(inne)n mehreren Theoriespuren gleichzeitig nachgegangen und damit geradezu inflationär gearbeitet.19) Andererseits weist das Untersuchungsmaterial in Abhängigkeit von der individuellen Forschungserfahrung beziehungsweise dem Lernprozess der Mitarbeitenden mitunter erhebliche Qualitätsunterschiede auf. Das Lehrforschungsprojekt war ursprünglich auf zwei Semester angelegt und wurde dann – mit fluktuierender Besetzung – um ein weiteres Semester verlängert. Am Ende lagen neben etwa 30 ausführlichen Interviews20) eine Vielzahl von Beobachtungsnotizen, kurzen Ad-hoc-Interviews sowie Recherche- und Theoriememos vor, welche die Grundlage für Seminararbeiten und darüber hinaus einige Bachelor-Abschlussarbeiten bildeten. [16]

Das Augsburger Universitätsviertel ist eine Trabantenstadt auf dem Gelände des alten Militärflughafens. Aufgebaut seit den 1970er Jahren, besteht es aus dem Unicampus im Westen und einer in zwei Phasen errichteten Wohnblockbebauung, um die sich ein Bestand an Einfamilien-, Doppel- und Reihenhäusern gruppiert. Das Viertel liegt am Stadtrand und grenzt an einen als Naherholungsgebiet erschlossenen Wald im Osten sowie landwirtschaftlich genutzte beziehungsweise zur gewerblichen Bebauung ausgewiesene Flächen im Westen. Gen Norden schließen sich ältere Stadtviertel an. Im Süden liegt ein weiterer, mittlerweile eingemeindeter Vorort. Von Anfang an war das Viertel aufgrund eines hohen Bestands an Sozialwohnungen erste Anlaufstelle für Migrant(inn)en – überwiegend aus Mittel- und Osteuropa. In Verbindung mit dieser Besiedelungsstruktur hat sich in den 1990er Jahren der Ruf als "Brennpunktviertel" etabliert, der sich trotz erfolgreicher Maßnahmen des Quartiermanagements bis heute hartnäckig hält. Zentrale Themen beziehungsweise Gegenstand der empirisch gestützten Theoriebildung waren somit Fragen der Sicherheit, der Migration, Integration oder Assimilation sowie Aspekte der subjektiven Strukturierung des sozialen Raumes im Bereich von Stadtsoziologie sowie Quartiersforschung.21) [17]

Diese Kontextinformation soll genügen, um den sich aus der forschungs- beziehungsweise methodendidaktischen Reflexion ergebenden Aspekt der Fallauswahl gemäß der Vorgehensweise beim Theoretical Sampling näher zu betrachten. Ausgangspunkt ist die Einsicht, dass diese Variante der Fallauswahl eine spezifische Form forschungsleitender Entscheidungen mit sich bringt, die sich nicht nur maßgeblich von anderen Spielarten der Fallauswahl in qualitativen Forschungszusammenhängen unterscheidet (vgl. COYNE 1997), sondern darüber hinaus bereits für sich als erkenntnisgenerierendes Instrument begriffen und entsprechend dokumentiert werden sollte. [18]

3.2 Entscheidungskriterien bei der Fallauswahl

Beim Versuch einer Klassifizierung von Entscheidungen der Fallselektion, die den beteiligten Studierenden als Leitlinien an die Hand gegeben werden sollte, zeigte sich, wie schwierig es war, die Strategien des Theoretical Sampling oder irgendeine Form eines verallgemeinerbaren Schemas auf die zuvor getroffenen Entscheidungen anzuwenden. Die empirische Praxis der Fallselektion brachte bei Weitem mehr Wahlmöglichkeiten hervor, als dies von den in der Literatur vorfindlichen Selektionsregeln abgebildet wird.22) Jede Auswahlentscheidung wurde zwar im Rahmen eines Memos dokumentiert; es stellte sich jedoch im Rückblick heraus, dass neben den jeweils erwähnten weitere Faktoren auf die Fallauswahl eingewirkt hatten. Dieser Umstand setzt zwar nicht die bestehenden Varianten außer Kraft, zeigt aber, dass eine angemessene Beschreibung des Theoretical Sampling einen Zugang erfordert, der in der Lage ist, eine größere Komplexität dieses letztlich forschungskonstitutiven Entscheidungszusammenhangs zu erfassen und zu reflektieren. Obwohl Forschende dies womöglich intuitiv in Erwägung ziehen werden, erschien es uns – nicht zuletzt aus methodendidaktischen Gründen – als unerlässlich, die Fallauswahlentscheidung weiter zu systematisieren. Es bietet sich an, davon auszugehen, dass die Auswahl einer weiteren Quelle nicht ein-, sondern multidimensional erfolgt. Damit reicht es nicht aus, von minimaler oder maximaler Kontrastierung zu sprechen, wenn diese Kontrastierungen an einer Vielzahl von Gesichtspunkten vorgenommen werden können. [19]

Die Kriterien der Fallauswahl beziehungsweise der Fallkontrastierung ergeben sich im Laufe der intensiven Auseinandersetzung der Forschenden mit ihrem Material. Ihre selektive Aufmerksamkeit steht auf einem heterogenen Fundament: Als relevant erachtete Fallmerkmale lassen sich einerseits aus der initialen Forschungsfrage ableiten, andererseits beruhen sie bereits auf der epistemologischen Grunddisposition der Forscher(innen). Diese Voreinstellung erwächst den im jeweiligen Fachdiskurs akzeptanzfähigen Basisdifferenzen. Sie zu vermitteln, zu tradieren und einzuüben ist fundamentaler Bestandteil der akademischen Ausbildung des jeweiligen Faches. In der Soziologie sind solche Grundunterscheidungen häufig soziodemografischer Art. Das konzeptgeleitete Verfahren des Theoretical Sampling gestattet und fordert jedoch die Entwicklung neuer kategorialer Differenzierungen. Diese müssen mit den im jeweiligen Forschungsmaterial aufscheinenden Relevanzsetzungen der Alltagshandelnden im Forschungsfeld korrespondieren und damit auf einer ergebnisoffenen Orientierung der Forschenden im Feld sowie dem jeweiligen Stand der datengegründeten Theoriearbeit basieren. Charakteristisch für die GTM ist somit eine fortlaufende Überprüfung des Arrangements forschungsleitender Grundmerkmale, die mindestens eine Fallauswahlentscheidung bestimmen können.23) [20]

Die Fallauswahl wird per Theoretical Sampling zu einem konstitutiven Moment der gesamten Forschungsarbeit. Sie beinhaltet für jeden einzelnen Selektionsschritt eine Reflexion über die pfadabhängig der bisherigen Konzeptualisierungsarbeit erwachsenen Relevanzen. Ein Festhalten an ein oder zwei forschungsleitenden Grundmerkmalen erscheint vor diesem Hintergrund als Sonderfall, der mit jeder weiteren, dieselben Differenzen bemühenden Fallentscheidung insofern problematischer wird, als gerade die Offenheit der Fallentscheidung das gesamte Vorgehen methodologisch konstituiert. Wenn sich aber die Auswahlkriterien ändern und nicht konstant gehalten werden können, gerät die Begründung jedes weiteren Feldkontakts zu einem für die Forschungsdokumentation wertvollen Berichtsmoment. Dasselbe gilt im Hinblick auf das Resultat der Theoriebildung, das nur nachvollzogen werden kann, wenn die Kriterien der Fallauswahl offenliegen. Mit anderen Worten: Forschende müssen ihren eigenen Erkenntnisfortschritt im Hinblick auf ihre Felderschließung dokumentieren. Diese Notwendigkeit wird bisher nur durch die Praxis des Memo-Schreibens anempfohlen, aber nicht systematisiert.24) [21]

Das Eingeständnis der Pluralität entscheidungsrelevanter Fallmerkmale hat Konsequenzen für den Vorschlag, das Sampling analog zum Kodieren zu gestalten (STRAUSS & CORBIN 1998 [1990]), indem man zunächst offen, dann axial und schließlich selektiv auswählt. Auch hier besteht das Problem einer Festlegung auf ein bestimmtes Arrangement von Merkmalen, welches die Einheit des Falles interpretativ repräsentiert. Die Ähnlichkeit zur Kodierpraxis ergibt sich an anderer Stelle. Die GTM gibt vor, auf der Grundlage der im Interpretationsprozess ermittelten Kategorien von Fall zu Fall voranzuschreiten. Damit akzentuiert sie die Berücksichtigung neu hinzutretender Einsichten. Nicht alle vergebenen Kodes und generierten Kategorien repräsentieren Grundmerkmale des Falls und charakterisieren damit den Forschungsgegenstand im Sinne der Forschungsfrage. Es empfiehlt sich daher eine permanente Bewertung von Kategorien hinsichtlich ihrer Relevanz als auswahlrelevante Fallmerkmale. Die Grenze einer Gleichsetzung von interpretativ generierten Kategorien und Selektionskriterien ist schnell erreicht, wenn konzeptuelle Überlegungen erkenntnisleitend werden, welche auf Kodes zurückgehen, aber schlecht explizierbar oder artikulierbar sind sowie "zwischen den Zeilen" gelesen und gebildet wurden. Wurde zum Beispiel eine implizit vorgebrachte Fremdenangst, die unter einer Semantik sozialer Erwünschtheit verdeckt war, rekonstruiert, erschien es als schwierig, explizit nach weiteren Fällen von Fremdenangst zu suchen. Die Beschränkung auf ein singuläres Merkmal der sich für die Rekonstruktion der Feldstruktur nach und nach als konstitutiv erweisenden und ständig anwachsenden Merkmalsmenge ist aus dieser Sicht problematisch. Die inkrementelle Praxis der Fallauswahl sollte demnach dem Umstand Rechnung tragen, dass jede erneute Fallentscheidung hinsichtlich ihrer Vorabkriterien (ex ante) und zugleich hinsichtlich der ihr zugrunde liegenden Merkmalsmenge (ex post) reflektiert werden muss. Dadurch wird es möglich, die bis zu einem bestimmten Zeitpunkt implizierten – und das heißt: nicht intendierten, aber latent wirkenden – Entscheidungsprämissen sichtbar werden zu lassen. Die sich mitunter im Forschungsprozess "zufällig" bietende günstige Gelegenheit eines außerplanmäßigen Datenzugriffs kann dann einerseits besser begründet werden. Andererseits legt sie die Spannbreite latenter Vorannahmen beziehungsweise legitimer Selektionslogiken offen. [22]

Die Fallauswahl ist nicht zuletzt ein multifaktorielles Geschehen, das überdies durch die Machtverhältnisse der Verständigung im Forschungsprozess beeinflusst wird. So hängt es von den Hierarchien und Partizipationsstrukturen der Forscher(innen)gemeinschaft ab, welche Leitdifferenzen für relevant erachtet und welche Datengewinnungsgelegenheiten als zielführend begriffen werden. Die Rekonstruktion der Fallauswahl muss daher berücksichtigen, wer in der Position beziehungsweise dazu legitimiert ist, ein bestimmtes Merkmalsarrangement durchzusetzen. [23]

Um diese komplexen epistemischen Spannungsverhältnisse zu reflektieren und abzubilden, schlagen wir die Verwendung von Verlaufskarten vor, die für jeden Datenerfassungsschritt erstellt werden. Sie enthalten neben der Benennung der Datenquelle, des Zugriffsdatums und der beteiligten Forscher(innen) eine Liste der vorab (ex ante) als relevant erachteten Merkmale, aus denen die Entscheidung zur Datengenese abgeleitet wurde. Außerdem beinhalten sie eine Liste der nach erfolgter Interpretation für relevant befundenen Merkmale – und gegebenenfalls sogar den Namen des Forschers oder der Forscherin, der/die für diese Setzung einsteht. Die Ex-post-Merkmale setzen sich somit teilweise aus den interpretativ ermittelten Kategorien und teilweise aus den Vorannahmen der Forschenden zusammen. [24]

Um die Verlaufskarten bearbeitbar zu halten, können nur bedeutsame Kategorien aufgenommen werden. Wenn die Interpretation gelingt, sollte dies nicht mehr als eine Handvoll neuer Momente umfassen. In Übereinstimmung beispielsweise mit den Memoing-Regeln bei STRAUSS (1998 [1987]) sollte zu jeder einzelnen Kategorie oder Prämisse ein Theoriememo erstellt werden, das als Kategoriendokumentation gegebenenfalls von Fall zu Fall fortgeschrieben wird. Dadurch werden Verlaufskarten zu einem Indikator für das Erreichen theoretischer Sättigung. Wenn das Forschungsprojekt keiner äußeren Limitation unterliegt, kann es so lange weitergeführt werden, bis alle relevanten Aspekte des Forschungsgegenstands vollständig verstanden und zu abstrahierenden Synthesen verknüpft worden sind. Was schlussendlich die Grundlage einer allgemeineren, aus dem Forschungsgegenstand entwickelten Theorie ist, kann bei bestimmten Arrangements von Merkmalskategorien jedoch auch schon vorher erreicht werden. Bei begrenzter Projektlaufzeit werden sich Forschende mit dem Kenntnisstand bescheiden, den sie zum Ende ihres Projekts erlangt haben. In ihrer Berichtslegung wäre dann aber auch darauf hinzuweisen, dass die theoretische Sättigung nicht erreicht werden konnte. Im Folgenden wird die Arbeit mit Verlaufskarten an dem Projekt zum Augsburger Universitätsviertel nachvollzogen. [25]

3.3 Verlaufskarten als Reflexions- und Dokumentationsinstrument

Die nachfolgend dargestellte Dokumentation eines Forschungsprozesses mithilfe von Verlaufskarten dient in erster Linie einer Rekonstruktion der Fallauswahl. In zweiter Linie bietet sie eine erkenntnisrelevante Ergänzung des Codebaumsystems, zu dessen Darstellungsform der Schlüssel- und (Sub-) Kategorien nun mit dem kategoriengeleiteten Fallauswahlkriterium eine weitere Darstellungsform hinzukommt. Der Zusammenhang aller Verlaufskarten eines Projekts gibt sowohl Auskunft über alle vergebenen Kodes als auch über diejenigen, welche für Fallauswahlentscheidungen relevant waren. Damit dokumentiert er einen Vorher-Nachher-Vergleich innerhalb der Erkenntnisgenese und zugleich den Relevanzakzent der jeweils neuen Datengenerierung für das Forschungsvorhaben.25) In weiteren Schritten lässt sich aber auch die Systematik und Regelhaftigkeit eines Auswahlprozesses im Ganzen nachvollziehen. [26]

Wir führen die Arbeit mit Verlaufskarten exemplarisch und im Rückgriff auf drei aufeinanderfolgende Interviews vor. Die so dokumentierte Entscheidungskette lässt sich mit Blick auf das weitere Untersuchungsmaterial fortsetzen, erfasst jedoch nur die im Projekt gesammelten Interviewdaten. In der folgenden Abbildung wird die Verlaufskarte des ersten Interviews im Projekt "Augsburger Universitätsviertel" mit Interviewtitel, -zeitpunkt und den fallauswahlrelevanten Vorannahmen und Kategorien dargestellt. Die Karte enthält erste Kategorien und dichotomisierte Kodes, wobei die empirisch nachgewiesene Merkmalsausprägung kursiv gedruckt ist.

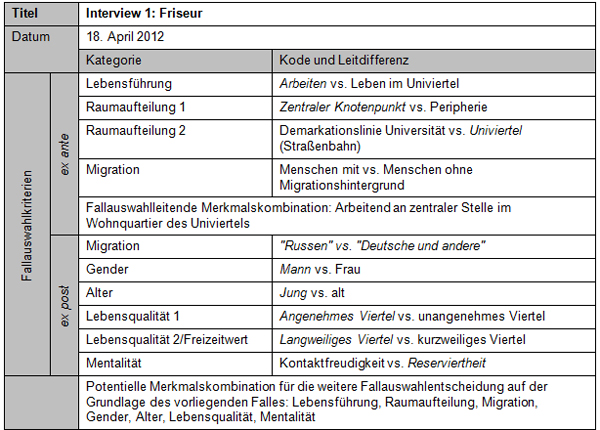

Übersicht 1: Verlaufskarte Interview 1 [27]

Die Verlaufskarte des Interviews 1 dokumentiert zunächst die Vorannahmen, welche zu der Entscheidung geführt haben, einen der ansässigen Friseure in seinem Laden zu befragen. Das Forschungsvorhaben hatte den Titel "Leben und Arbeiten im Universitätsviertel", was eine dreifache Fallselektion implizierte: Erstens konnte nach einem Fall gesucht werden, bei dem "Arbeiten" und "Leben" im Universitätsviertel zusammenfallen. Zweitens wurde – unter der Maßgabe einer Trennung der beiden Aspekte von Lebensführung – nach einem Fall für den Aspekt "Leben" beziehungsweise Wohnen und drittens nach einem Fall für den Aspekt "Arbeiten" Ausschau gehalten. Die Entscheidung fiel auf "Arbeiten", woraufhin die Ladengeschäfte des Quartiers in den Blick rückten. Aufgrund der Common-Sense-Annahme, dass Friseur(inn)e(n) besonders viel sowohl über das "Leben" als auch über die "Arbeit" erfahren können, wurde ein Laden im Zentrum des Viertels ausgewählt. Dabei kam außerdem die mit der räumlichen Struktur verbundene Annahme zum Tragen, dass das Viertel – zumindest der Häufung an Geschäften nach zu urteilen – eine Trennung in Zentrum und Peripherie aufweist und dass eine Besonderheit in seiner Aufteilung in Universität und Wohnquartier besteht; beide Gebiete werden durch eine Straßenbahntrasse – gleichsam einer Demarkationslinie – voneinander getrennt. Weitere möglicherweise relevante Vorannahmen, die zum Zeitpunkt der Wahlentscheidung noch unberücksichtigt geblieben waren, sind das Vorwissen um die große Zahl von Bewohner(inne)n mit Migrationshintergrund sowie die Historie der Bebauungsphasen des Viertels, die eine Unterscheidung in ältere (Nord-) und neuere (Süd-) Bausubstanz, Sozial- und Eigentumswohnungsbau und damit verbunden auch eine Segregation in ärmere und wohlhabendere Anwohner(innen)schaft nahelegt. Mit Blick auf die Diskussion zur Problematik der Ausgangssituation eines mit Theoretical Sampling verbundenen Forschungsprozesses schließt dies an Positionen an, bei denen eine interpretative Ausgangsidee zugrunde gelegt wird (vgl. die Diskussion des ersten Feldzugangs bei BECKENRIDGE & JONES 2009). Mit anderen Worten bedarf es, um den Prozess in Gang setzen zu können, entweder einer vagen Vorstellung, nach was man sucht, einer Ausgangsirritation oder eines speziellen Ausgangsverdachts, der den ersten Schritt legitimiert. Aber auch diese frühe Intuition ist so begründungsrelevant wie theoriekonstitutiv. [28]

Die Auswertung des unmittelbar nach der Durchführung transkribierten Interviews erbrachte sechs zentrale Themen (Kategorien, im Folgenden kursiv), die im Folgenden als Suchheuristiken dienten. Hierbei ist zwischen "harten" und "weichen" Kriterien zu unterscheiden: Strukturmerkmale wie Geschlechtszugehörigkeit, Alter oder Wohnlage sind in der Regel identifizierbar. Schwieriger wird es bei evaluativen Einschätzungen oder Meinungen, die ebenfalls von heuristischem Wert sein können, aber weitere Identifizierungshypothesen voraussetzen. [29]

Im nun vorliegenden und ausgewerteten Material wurden drei Strukturkategorien benannt: Da die befragte Person selbst einen Migrationshintergrund aufwies und diesen ebenso wie die besondere Bevölkerungsstruktur des Viertels explizit thematisierte, lag es für die Forscher(innen) nahe, Migration als Kategorie beizubehalten. Allerdings entsprach die Herkunft des Befragten – er stammt aus der Türkei – nicht der mit Migrationshintergrund verbundenen Erwartung. Für weitere Fälle lag es daher nahe, den Blick gezielt auf Spätaussiedler(innen) zu richten. Die männliche Geschlechterzuordnung war nicht nur ein demografischer Sachverhalt; viele Aspekte seiner Interviewerzählung adressierten männliche Verhaltensstereotype, was auf die Kategorie Gender verwies. Im engeren Sinn handelte es sich um Verhaltensweisen eines jüngeren Mannes, weshalb die zunächst dichotome Lebensphasenkategorie Alter aufgenommen wurde. Sowohl die Geschlechtszugehörigkeit als auch das Alter des Befragten waren keine vorab festgelegten Auswahlkriterien; sie ergaben sich aus der Gelegenheit, zufällig eine jüngere Person männlichen Geschlechts anzutreffen. Erst in der Interpretation wurde deutlich, dass die beiden Aspekte auch relevante Themen des Interviews waren. Hinzu kamen drei evaluative Kategorien, die ihrerseits mittelbar als Suchheuristiken hätten dienen können. So kam der Befragte auf die Lebensqualität im Viertel zu sprechen, das er als besonders "angenehm" beschrieb. Abstriche machte er allerdings beim Freizeitwert, indem er dem Quartier attestierte, "langweilig" zu sein. Ein viertes zentrales Thema des Interviews bezog sich auf die Mentalität der Augsburger Stadtbevölkerung. Sie wurde als eher distanziert oder reserviert beschrieben. [30]

Mit Blick auf die weitere Vorgehensweise und im Rückgriff auf die Selektionspraxis der Kontrastierung kann man bei den Ausprägungen der Kodes dichotome Paare bilden, die Kriterien für weitere Schritte des Theoretical Sampling liefern.26) Diese nachfolgenden Schritte können sich nun auf ein erweitertes Wissen über den Forschungsgegenstand Universitätsviertel stützen. Dabei bleiben die Vorannahmen als entscheidungsrelevant bestehen; ergänzt werden sie durch die neu hinzugetretenen Aspekte. Deutlich wird, dass sich anschließende Vergleichsoperationen wie zum Beispiel eine maximale oder minimale Kontrastierung im Hinblick auf den nächsten auszuwählenden Fall kaum auf ein einzelnes Merkmal beziehen werden. Die Selektion ist nun wieder eine Entscheidung für eine bestimmte Merkmalskombination, die sowohl maximal als auch minimal kontrastierend sein kann. [31]

Mit Blick auf das Universitätsviertelprojekt lässt sich nun der Übergang zum zweiten per Theoretical Sampling ermittelten Interview rekonstruieren: Die Fülle an forschungsleitenden Kategorien aus Vorannahmen und Interpretationsergebnissen war bereits zu diesem Zeitpunkt so hoch, dass keine eindimensionale Kontrastierung möglich war, weshalb eine Reduktion der im nächsten Schritt forschungsleitenden Kategorien vorgenommen werden musste. Die Diskussion innerhalb des Forschungsseminars führte dazu, zunächst die Vorannahmenkategorie der Lebensführung kontrastiv einzusetzen und nach einer Person zu suchen, die zumindest nicht auf den ersten Blick im Universitätsviertel arbeitete. Die beiden Raumaufteilungskategorien wurden beibehalten, indem die Zielperson im Zentrum des Quartiers und dort im Wohn-Bereich gesucht wurde. Außerdem fiel die Entscheidung, die Kategorie Migration minimal zu kontrastieren und eine weitere Person mit Migrationshintergrund zu suchen. Eine kontrastive Selektion sollte jedoch bei Geschlechtszugehörigkeit und Alter vorgenommen werden, wobei von einer Berücksichtigung der zunächst als kompliziert erachteten evaluativen Kategorien Abstand genommen wurde. Damit ergab sich aus den Strukturkategorien das Suchschema, im Zentrum des Wohnquartiers nach einer älteren weiblichen Person mit osteuropäischem Migrationshintergrund Ausschau zu halten. [32]

Die folgende Verlaufskarte zeigt die zweite, sich aus der Auswertung des Gesprächs mit dem Friseur (Interview 1) ergebende Entscheidungsdokumentation im Hinblick auf das Interview 2:

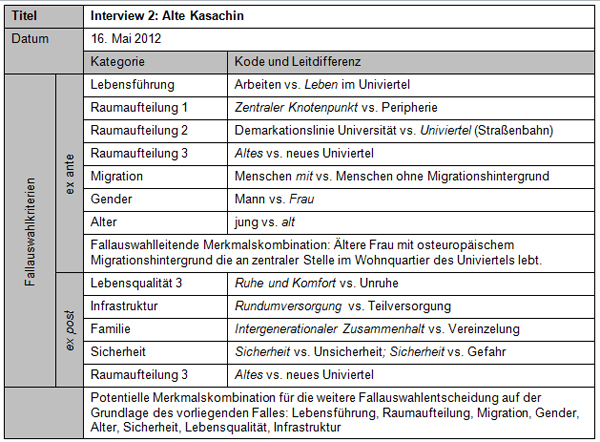

Übersicht 2: Verlaufskarte Interview 2 [33]

Die Verlaufskarte des Interviews 2 gibt Aufschluss zum einen über vorgefundene (kursiv) und erwartete Ausprägungen von Kategorien, die zum konkreten Sample (in diesem Fall einem Interview) führten (ex ante), zum anderen über tatsächlich ermittelte Ausprägungen in der ersten Interpretationsphase nach dem Interview (ex post). Zur weiteren theoretischen Sensibilisierung – und zur Vorbereitung der nächsten Fallauswahl – wurden Letztere mit weiteren Ausprägungen kontrastiert. Die Reflexion der ex post untersuchten Kategorien ergab eine Suchheuristik für weitere Samples, zusammengefasst am unteren Rand der Karte. [34]

Die im Zentrum des Wohnquartiers "Universitätsviertel" durchgeführte Suche nach einer älteren Dame mit osteuropäischem Migrationshintergrund brachte einen Interviewtermin mit einer Seniorin aus Kasachstan ein. Zu ihrem Eindruck vom Universitätsviertel befragt, erzählte sie von ihrer aktuellen Lebenssituation und nahm Bezug auf ihr früheres Leben in der Sowjetunion sowie in Kasachstan. Dabei ließen sich vier Kategorien ausmachen, von denen mindestens zwei nicht nur demografische, sondern vor allem auch evaluative Bedeutungszumessungen enthielten: Erstens lieferte die Befragte eine Ergänzung zur Kategorie Lebensqualität, indem sie die Ruhe und den Komfort des Wohnquartiers lobte. Dieser Befund deckte sich mit diesbezüglichen Äußerungen im vorangegangenen Interview. Hinzu kam ein neuer Aspekt, der vor allem für ältere Menschen von Belang ist. So wurde die Versorgungsinfrastruktur des Viertels als gut eingeschätzt. Vor allem die kurzen Wege zu Lebensmittelgeschäften und Arztpraxen standen hierbei im Fokus. Ein weiterer Punkt war die Familie: Die Befragte war mit Verwandten unterschiedlicher Generationen nach Deutschland gekommen. Sie erzählte von ihrem kranken Ehemann, dessen Versorgung sie im Universitätsviertel als sehr gut gewährleistet sah. Außerdem berichtete sie von ihren erwachsenen Kindern, die beide in Arbeits- beziehungsweise Ausbildungsverhältnissen stünden, von ihrer bereits verstorbenen Tante, welche die Migration angeregt und vorangetrieben hatte sowie von ihrem verstorbenen Vater und ihrer Mutter. Die vierte Kategorie, die bei der Auswertung des Interviews relevant schien, behandelte das Thema Sicherheit, welches für die Befragte von großer Bedeutung war und sich sowohl auf Versorgungs- und Beschäftigungssicherheit als auch auf den Schutz vor Kriminalität bezog. Die letzte Kategorie, die sich aus der Interpretation des Interviews ergab, betrifft den empirisch bis dahin unberücksichtigten Vorwissensaspekt der Segregation des Viertels in einen Teil (altes Universitätsviertel) mit höherem und einen (neues Universitätsviertel) mit geringerem Migrationsanteil, verbunden mit einem höheren sozioökonomischen Lebensstandard. [35]

Die Auswertung des zweiten Interviews zeigte zunächst, dass sich die Zahl der auswahlrelevanten Kategorien weiter erhöht hatte und nicht mehr alle Aspekte bei der nächsten Fallselektion würden berücksichtigt werden können. Weitere Entscheidungen waren nötig. Deutlich wird damit auch, dass die Entwicklung "gegenstandsbezogener" Theorieperspektiven ebenso wie die "theoretische" Sättigung insbesondere bei explorierender Forschung nicht "objektiv" dem Gegenstand erwachsen, sondern überwiegend auf Selektionsentscheidungen von Forscher(inne)n zurückgeführt werden müssen. Dementsprechend entstand die folgende Wahl wiederum im Rückgriff auf nur wenige Aspekte, die minimal beziehungsweise maximal kontrastiert wurden: Für die nächste Kontaktaufnahme wurde vorgesehen, eine Person ohne Migrationshintergrund anzusprechen. Beibehalten wurden die räumlichen Gesichtspunkte der zentralen Lage im Wohnquartier des Universitätsviertels sowie der Lebensführungsaspekt "Leben", wobei als weiterer und neuer Kontrast nun der Blick auf den jüngeren Baubestand gelenkt wurde. [36]

Die folgende Verlaufskarte bezieht sich auf dritte, aus der Auswertung des Gesprächs mit der älteren Dame mit Migrationshintergrund (Interview 2) folgende Interview 3:

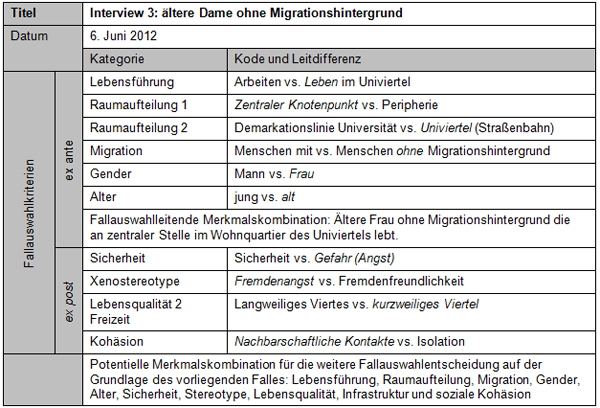

Übersicht 3: Verlaufskarte Interview 3 [37]

Das dritte Interview wurde im neuen Universitätsviertel auf der Suche nach einer Person ohne Migrationshintergrund realisiert: Eine ältere Dame fand sich bereit, über ihr Leben im Quartier Auskunft zu geben. Es handelt sich hier um eines von drei vergleichsweise kurzen Ad-hoc-Interviews, die mit Passant(inn)en geführt wurden, wobei sich bei den anderen Befragungen herausstellte, dass man es wider Erwarten mit Personen mit Migrationshintergrund zu tun hatte. Das Gespräch mit der Dame war somit das einzige, das die Vorgaben der Sampling-Entscheidung korrekt umsetzte. Die anderen beiden Interviews wichen zwar von der Selektionsvorgabe ab, lieferten aber gleichwohl wertvolle Informationen zum Forschungsgegenstand. Die forschungspragmatische Verletzung der Sampling-Strategie erscheint dabei als ein Indiz für die Kontingenz explorierender Forschungsprozesse. [38]

Die Dame ohne Migrationshintergrund entfaltete ein zentrales Thema, das von drei randständigeren Aspekten flankiert wurde. Daraus entstanden vier überwiegend evaluative Kategorien. Der hauptsächliche Gegenstand des Interviews lässt sich der Kategorie Sicherheit mit der Dichotomie von Sicherheit und Gefahr zuordnen, wobei Aspekte von Angst vor kriminellen Übergriffen im weiteren und Gewaltkriminalität im engeren Sinn thematisiert wurden. Am Rande wurde diese Angst – zum Beispiel nachts allein auf die Straße zu gehen – mit Xenostereotypen verknüpft. So etikettierte die Befragte "die Russen" als oft "betrunkenen Pöbel", der in Tiefgaragen Autos aufbräche. Abseits dieser kritischen Sicht auf die eigene Wohnumgebung wurde dem Viertel in puncto Lebensqualität ein angemessenes Angebot an Freizeit- und Begegnungsmöglichkeiten im Sinne von Straßenkultur (Straßenfeste) attestiert und auf soziale Kohäsion durch nachbarschaftliche Beziehungen hingewiesen. [39]

Erneut erhöhte sich in diesem dritten Interview mit der Anzahl vorgefundener Themen beziehungsweise Kategorien auch die Zahl forschungsrelevanter Aspekte, denen in weiteren Interviews nachgegangen werden konnte. In der Diskussion unter den Projektmitarbeiter(inne)n kristallisierten sich unterschiedliche Interessen heraus, was zur Differenzierung des Projekts im Sinne einer Eröffnung weiterer Pfade sowie zur Entwicklung mehrerer Schlüsselkategorien führte. [40]

Eine zentrale Kategorie begann sich allerdings schon zu diesem frühen Zeitpunkt abzuzeichnen: Da es in diesem Artikel um die Reflexion der Fallauswahlentscheidung mithilfe eines Dokumentationsinstruments geht, soll nun anhand eines Beispiels gezeigt werden, welche Richtung die Kategorienbildung auf der Grundlage dieser Fallauswahl genommen hat. [41]

Erwartungsgemäß entstand aus den Einschätzungen der Bewohner(innen) ein facettenreiches Bild des Quartiers, in dem sich die Geschäftsleute auf die ethnisch gemischte Bevölkerung einstellen, in dem unter dem Aspekt der Sicherheit ein Geborgenheitsgefühl der Zugewanderten einer diffusen Angst der Eingesessenen gegenübersteht und in dem sich die heterogene Einwohner(innen)schaft mit Migrationshintergrund äußerst kritisch hinsichtlich der Assimilationsanstrengungen einzelner Gruppen selbst beobachtet. Hierbei wird auch die sozialräumliche Segregation zwischen dem alten und dem neuen Viertel thematisch, wobei der alte Teil nach wie vor als erste Anlaufstelle für Neuankömmlinge und als Wohngegend für sozial Schwache fungiert, hingegen der neue Teil diejenigen beherbergt, die bessergestellt sind und zu einem nicht unerheblichen Anteil auf eine "gelungene" Integrationsgeschichte zurückblicken. [42]

Als zentrales Motiv dieser Erzählungen erwies sich ein vielfältig differenzierter Raumbezug, der sich einerseits in Hinweisen auf die Topologie des Viertels hinsichtlich ihrer funktionalen Bedeutung und andererseits in Metaphern einer evaluativen Bedeutungszumessung des sozialen Raumes im Ganzen manifestierte. Die auf diese Weise entwickelte Schlüsselkategorie Subjektive Partitionierung des Sozialraums ermöglichte es, Nutzungs- und Bewertungsperspektiven sehr unterschiedlicher Bevölkerungsgruppen des Viertels aufeinander zu beziehen und zu vergleichen. Deutlich wird dann beispielsweise, welche Räume aus welchen Gründen häufig aufgesucht werden und wer welche Räume als gefährliche Orte identifiziert. Aufschlussreich ist zudem, dass es gruppenspezifische Binnendifferenzierungen oder Demarkationslinien innerhalb des Viertels ebenso zu geben scheint, wie die Außengrenzen des Viertels mitunter unterschiedliche Bedeutungshorizonte aufweisen (vgl. hierzu DIMBATH et al. 2018). [43]

Die vorgängig präsentierte Rekonstruktion der "theoriegeleiteten" Vorgehensweise bei der Fallauswahl mündet erstens in die Frage nach der Qualität der Befunde vor dem Hintergrund ihrer Angemessenheit und Nachvollziehbarkeit: Handelt es sich bei den so erzeugten Ergebnissen um eine mit der Individualität der Forschenden verbundene einzigartige Figur, oder liegt dieser Bewegung vom Speziellen zum Allgemeinen ein generalisierbares Moment zugrunde, durch das die Analyse dem Untersuchungsmaterial gerecht wird? Die Reflexion mithilfe von Verlaufskarten liefert keine objektiv richtigeren Erkenntnisse, aber sie macht nachvollziehbar, wann eine Interpretationsgemeinschaft welche Relevanzzumessung vorgenommen und welche Konsequenzen sie daraus gezogen hat. Ersichtlich wird dann auch, wann welche Kategorie im Verlauf des Forschungsprozesses entwickelt oder eingeführt beziehungsweise wann sie auf welche Weise präzisiert, profiliert oder differenziert wurde. Verlaufskarten dienen somit zugleich einer Dokumentation zur Selbstvergewisserung im Forschungsprozess und der Qualitätssicherung im Hinblick auf die Nachvollziehbarkeit der gewonnenen Einsichten. [44]

Zweitens ist die Frage zu stellen, ob Forschungsprojekte, die mit der GTM arbeiten, mit Blick auf das in ihnen häufig anzutreffende kollaborative Vorgehen mehrerer Forschender mithilfe von Verlaufskarten besser reflektiert werden können. Mit der sukzessiven Erkenntnisgenese, die aus der Prozesslogik des Theoretical Sampling folgt, ist nicht ausgemacht, dass man irgendwann gegenstandsbezogen – und nicht etwa aufgrund der begrenzten Ressourcen – zum Ende kommt. Vor allem bei größeren Forschungsgruppen, die nicht durch eine(n) charismatische(n) und erfahrene(n) Supervisor(in) gelenkt werden, kann die kollaborative Exploration ebenso gut auf eine Diffusion und nicht auf eine Fokussierung von Kategorien hinauslaufen.27) Mit jeder neu ansetzenden und ergebnisoffenen Analyse des Materials stellen sich Erkenntnisse ein, die neue Orientierungen und damit weiterhin offene Sampling-Entscheidungen nach sich ziehen können. Hinzu kommt, dass ein Personalwechsel im Forscher(innen)team wieder andere Relevanzsetzungen mit sich bringen kann. Wird auf den Verlaufskarten die Kategorieninformation um eine Protokollierung der entscheidungsleitenden Interpret(inn)enbeiträge ergänzt, ist insgesamt ein doppelter Ertrag zu erwarten: Die gesonderte Dokumentation der Verkettung von Fallauswahl und Fallinterpretation hilft dabei, die Arbeitsweise der Teams zu reflektieren. Sie kann ferner dazu beitragen, gruppendynamische Effekte sichtbar zu machen, die mitunter aus der wechselseitigen kollegialen und bisweilen hierarchischen Dynamik innerhalb von Teams erwachsen. Daraus folgt, dass durch die immanent verständigungsorientierte Vorgehensweise der GTM sich das Ende des Forschungsprozesses nicht aus dem Gegenstand28) ergibt, sondern maßgeblich aus der Interaktion mit dem Forschungsfeld und der Verständigungsdynamik innerhalb der Forscher(innen)gruppe. [45]

Drittens lässt sich fragen, ob die Verwendung von Verlaufskarten nicht zu einer Bürokratisierung des eigentlich freien und Kreativität ermöglichenden Verfahrens führt. Verlaufskarten stellen eine Sonderform des in der GTM vorgesehenen Memoings dar. Sie unterscheiden sich allerdings darin, dass Memos gleich einem Forschungstagebuch in erster Linie ein iteratives Ideenprotokoll darstellen. Die Verlaufskarte akzentuiert einen bestimmten, immer wiederkehrenden Aspekt und installiert eine standardisierte Memo- oder Reflexionsroutine von Fallauswahlentscheidungen. "Bürokratisch" im schlechten Sinn wäre es, wenn am Ende alle Verlaufskarten im Ordner mit den Forschungsmaterialien ungenutzt archiviert würden. Verlaufskarten erweisen sich demgegenüber dann als potentes Hilfsmittel, wenn sie systematisch zur Integration konzeptueller Überlegungen und zur Unterstützung einer finalen Berichtslegung eingesetzt werden. Sie dienen dann als hilfreiches konzeptbildendes Reflexionstool und wertvolle Gedächtnisstütze hinsichtlich der Gewordenheit des am Ende zu berichtenden kategorialen Zusammenhangs. [46]

In diesem Beitrag ging es darum, die praktische Arbeit mit dem Verfahren des Theoretical Sampling zu reflektieren. Es wurde davon ausgegangen, dass die sukzessive, mit der Datenauswertung verkettete Fallauswahl qualitativ-interpretativen Verfahren angemessener ist als die bei quantifizierend-erklärenden Zugängen übliche repräsentative Stichprobenziehung oder die auch in qualitativen Zugängen gebräuchliche, vorab festlegende selektiv-zielgerichtete Fallauswahl. Allerdings wurde auch konstatiert, dass dieser alternative Zugang empirisch wie theoretisch unterbestimmt ist. Ein zentraler Punkt ist hierbei die Frage nach den Praktiken des Entscheidens im Forschungsprozess, der am Beispiel eines Lehrforschungsprojekts aus der Quartierforschung nachgegangen wurde. Im Zentrum stand die Rekonstruktion der sukzessiven Fallauswahl bei der explorativen Erkundung des Augsburger Universitätsviertels. Es wurde deutlich, dass sich bei der Bewegung von einer offenen Felderschließung hin zu einer fokussierten nicht nur ein Pfad zu einem Sättigungspunkt abzeichnet, sondern eine Vielzahl von Aspekten zu berücksichtigen ist. Die sich daraus ergebende Selektionserfordernis ist "multifaktoriell" und muss innerhalb der Interpret(inn)engemeinschaft ausgehandelt werden. Welcher Logik das Projekt letztlich folgt, lässt sich weder vollends aus dem Forschungsgegenstand noch aus den methodologischen Prämissen des Forschungsprozesses ableiten, sondern vor allem auch aus der Zusammensetzung und Dynamik der Forscher(innen)gruppe. Sie trifft die Entscheidungen bei der Felderschließung, der Modifikation und Justierung der Forschungsfragen und definiert im Idealfall, ob respektive wann ein Zustand der Sättigung erreicht wurde. [47]

Mit Blick auf eine soziologische Analyse qualitativer Forschung werden in diesem Zusammenhang weitere Probleme aufgeworfen. Wenn es um eine bessere Reflexion der empirischen Forschungspraxis geht, können bei der Nutzung der GTM folgende interdependente Einflussgrößen berücksichtigt werden: die Größe der unmittelbar im Projekt engagierten Forscher(innen), die Dynamik dieser Gruppe im Spannungsfeld von erfahrenen/unerfahrenen, unter-/übergeordneten oder auch extrovertierten/introvertierten Personen sowie schließlich die Fluktuation der Gruppenmitglieder als Irritation von im bisherigen Forschungsverlauf etablierten Relevanzsetzungen. [48]

Auch wenn die hier vorgestellten Überlegungen nur kursorisch sind und einer Erweiterung und Vertiefung bedürfen, enthalten sie klare Hinweise einerseits in Richtung einer weiteren Durchdringung und Reflexion qualitativer Forschungspraxis. So ist mit Blick auf eine Weiterentwicklung des hier vorgestellten Instruments denkbar, die durch Verlaufskarten erfasste erkenntnisgenerative Fallauswahl auch auf Räume der Felderschließung zu übertragen, wodurch dem gegenwärtig akzentuierten Aspekt der Karteikarte die Information einer Landkarte beigestellt werden könnte. Andererseits öffnen die Verlaufskarten den Blick auf eine neue Dimension in der Debatte um die Gütekriterien29) qualitativer Forschung, da sich die Forschenden hier weder zum Instrument einer Forschungsprogrammatik objektivieren noch in ihrer Intentionalität hinter das Gebot der Einklammerung von Vorwissen (Epoché) zurückziehen können. Es geht darum, den Zusammenhang zwischen Forschungspraxis und Selektivität der Forschungsbefunde zu reflektieren und sichtbar sowie nachvollziehbar zu machen. [49]

Wir bedanken uns bei den Studierenden des Lehrforschungsprojekts "Leben und Arbeiten im Augsburger Universitätsviertel" und bei den beiden Gutachter(inne)n für ihre intensive Auseinandersetzung mit unserem Manuskript und die instruktiven Kommentare.

1) Wir gebrauchen den deutschen Begriff "Fallauswahl" als Übersetzung des englischen Wortes "sampling". Wenn wir von Fällen sprechen, meinen wir die Untersuchungseinheiten, zum Beispiel Personen, Gegenstände, Dokumente, Statistiken oder Forschungsliteratur, die aufgrund konzeptbasierter Fallauswahlentscheidungen (Theoretical Sampling) in das Datenkorpus aufgenommen werden. Die dabei generierten Daten beziehungsweise Forschungsartefakte repräsentieren schließlich den konzeptuellen Zusammenhang des Forschungsgegenstands wie auch die Wege des Forschungsprozesses. <zurück>

2) Bezogen auf Theoretical Sampling als Entscheidungsprozess siehe auch LAMNEK (2005, S.315). <zurück>

3) Die Rede von einem "Tool" beziehungsweise "Werkzeug" suggeriert eine faustregel- oder rezeptartige Verwendung. Aus diesem Grund sei davor gewarnt, aus den hier unterbreiteten Vorschlägen Verfahrensregeln und -vorschriften abzuleiten – es geht, ganz im Sinne von STRAUSS (1998 [1987], S.33), nur um Verfahrenshilfen, die sich bei manchen Orientierungen im Forschungsprozess als nützlich erweisen können. Allerdings dienen gerade Visualisierungen der Erkenntnisgewinnung, nicht zuletzt, indem sie die Dynamik von Problemfindung und Problementwicklung stimulieren (vgl. hierzu STRATKÖTTER 1996). <zurück>

4) DRAUCKER, MARTSOLF, ROSS und RUSK (2007) haben im Bereich der Gesundheitsforschung über 20 Studien, in denen die Forscher(innen) ihre Fallauswahl auf das Theoretical Sampling stützen, einer näheren Betrachtung unterzogen. Dabei kommen sie zu der Einschätzung, dass die Verzahnung von Auswertung und Datenselektion oft nicht erwähnt oder transparent gemacht wird. Die Autor(inn)en fanden nur eine Studie (nämlich WILSON, HUTCHINSON & HOLZEMER 2002), in der die Datenauswertung transparent dokumentiert wurde und zu einer gewichtigen Abänderung der Schwerpunktsetzung führte. <zurück>

5) Die Vereinnahmung der GTM für die Auswertung qualitativer Daten ist im Übrigen umstritten. So betonen GLASER und HOLTON (2004), dass die GTM sich nicht auf qualitative Datenanalyse (QDA) reduzieren lasse. BRECKENRIDGE und JONES (2009) argumentieren, dass die GTM als eine allgemeine Methodologie zu verstehen sei, die für die Verwendung von qualitativen und quantitativen Daten offen sei. Zwei Feststellungen sind zentral: Erstens können und sollen in Daten gründende Theorien im Sinne der GTM verfahrensseitig den Ansprüchen an hypothetico-deduktive Forschung und deduktiv-nomologische Erklärung nicht gerecht werden. Zweitens ist die Vorgehensweise der GTM für Forschungsperspektiven auf Grundlage des sogenannten "interpretativen Paradigmas" (KELLER 2012; WILSON 1970) unmittelbar anschlussfähig. <zurück>

6) KELLE und KLUGE (2010, S.23) argumentieren gegen das induktivistische und empiristische Selbstmissverständnis in Teilen der qualitativen Forschung, da "qualitativ entwickelte Konzepte und Typologien gleichermaßen empirisch begründet und theoretisch informiert sein müssen". Gleichzeitig betonen sie, dass es "empirisch gehaltloser", tendenziell heuristischer Konzepte bedürfe, um qualitative Forschung in ihrem "Entdeckungszusammenhang" anzuleiten. <zurück>

7) GLASER (1965) spricht zunächst im Rahmen der später als GTM bezeichneten "Constant Comparative Method" von Kodieren. Erst nach einiger Zeit rückt das Kodieren in das Zentrum der methodischen Debatte. Für STRAUSS (1998 [1987], S.48f.) ist Kodieren ein "[a]llgemeiner Begriff für das Konzeptualisieren von Daten". U.a. GLASER (1978), STRAUSS (1998 [1987]) sowie STRAUSS und CORBIN (1998 [1990]) haben diverse Vorschläge zur verfahrensseitigen Klärung des Kodierprozesses unterbreitet. Einen Überblick zum Debattenstand sowie eine Diskussion dieses Prozesses und seiner Herausforderungen liefert HOLTON (2007). <zurück>

8) Weder können z.B. ausschließlich Interviewdaten mit Interviewdaten verglichen werden, noch ist es möglich, geschweige denn erstrebenswert, Interviews oder Beobachtungen durch normierte Instrumente (z.B. Leitfäden) zu standardisieren. <zurück>

9) GUETTERMAN (2015) hat die Praxis der Fallauswahl in qualitativen Studien auf Grundlage der 51 meistzitierten Studien in den Bereichen education und health sciences untersucht. Sein Vergleich basiert auf der Berücksichtigung von Sample-Größe und der jeweilig veranschlagten Praxis der Fallauswahl über verschiedene qualitative Forschungsansätze hinweg. Der vornehmlich quantifizierend angelegte Vergleich verdeutlicht die große Spannweite von Sample-Größen in qualitativen Forschungsarbeiten. Das Verfahren des Theoretical Sampling ist Artikeln, die sich auf die GTM berufen, eigen. Der Befund, dass Arbeiten, die sich auf GTM mit ihren theoriekonstitutiven Kernmerkmalen Theoretical Sampling und Sättigung (saturation) stützen, in der Regel deutlich kleinere Sample-Größen aufweisen als Arbeiten, die andere Sampling-Strategien referieren, kann als Indiz für die relative Effizienz des Theoretical Sampling gelesen werden. Sofern es um eine transparente Verfahrensreflexion geht, schlussfolgert GUETTERMAN gleichwohl grundsätzlich: "The procedural detail surrounding sampling, case selection, and the extent of data collection was vague in general" (§40). <zurück>

10) Vgl. hierzu auch EISENHARDT (1989), die die Sättigung mit einer Minimierung empirischer und theoretischer Befunde im inkrementellen Forschungsprozess assoziiert. <zurück>

11) In einer weiteren Metastudie zur Praxis der Fallauswahl kann MASON (2010) zeigen, dass in Qualifikationsarbeiten (PhD) verhältnismäßig große Samples für die Sättigung der Theoriearbeit zusammengestellt werden. Er führt dies auf drei mögliche Ursachen zurück: erstens, weil das Konzept der Sättigung (saturation) nicht verstanden werde; zweitens aus defensiven Gründen, um Legitimationsansprüchen im Hinblick auf Fallzahlen zu entsprechen; und drittens, weil bei der Ankündigung der Arbeit eine gewisse Sample-Größe veranschlagt wurde und diese Ankündigung dann auch eingeholt werden soll (§56). Vor allem im Hinblick auf den ersten Aspekt verspricht eine forschungspraktische Diskussion des Theoretical Sampling einen hilfreichen Beitrag zur Klärung des Vorgehens. <zurück>

12) Die Schlüsselstellung des Theoretical Sampling betonen auch CORBIN und STRAUSS (1990, S.15): "The more systematic and widespread the theoretical sampling, the more completely the conditions and variations will be discovered, permitting greater generalizability, precision, and predictive capacity." Nach BRYANT (2009, §67) ist aus pragmatistischer Warte die Verschränkung von Datenanalyse und Datensammlung im Theoretical Sampling gar der "key to GTM" per se. <zurück>

13) TRUSCHKAT et al. (2011) diskutieren diese in einigen Schriften der Entwickler(innen) der GTM ausgeführten Inkonsistenzen kritisch. So werde einmal davor gewarnt, methodologische Empfehlungen als Rezeptwissen anzuwenden und dadurch die gebotene Offenheit zu verletzen, ein andermal vor einer Verwässerung der Methoden in der Praxis. <zurück>

14) In Arbeiten zur GTM ist dieses Problem seit Längerem bekannt. Die entscheidende Rolle und die Notwendigkeit der Reflexion von Vorannahmen seitens der Forschenden betonen KLUGE (1999), KELLE und KLUGE (2010) auch im Anschluss an Imre LAKATOS (1982); ähnliche Hinweise finden sich auch bei CLARKE (2005). Eine umfassende Diskussion dieser Auseinandersetzung um die Reflexivität von GTM-Forschenden findet sich bei MRUCK und MEY (2019). <zurück>

15) Innerhalb der GTM-Debatte finden diverse Abgrenzungsbewegungen statt. CHARMAZ (2006, S.129) stellt eine "konstruktivistische" einer "objektivistischen" GTM gegenüber. Insbesondere den Arbeiten GLASERs, aber auch der ursprünglichen GTM-Konzeption von GLASER und STRAUSS weist sie das Label "objektivisch" zu, während sie die neuere Diskussionsbeiträge in Anschluss an STRAUSS und ihren eigenen Ansatz als "konstruktivistisch" bezeichnet , da diese Ansätze die Prozesse der eigenen interpretativen Theoriekonstruktion reflektierten. CLARKE (2005, S.31f.) stellt der "traditional/positivist"-Orientierung von GLASER und STRAUSS eine "postmodern/constructivist" Orientierung gegenüber, der sie sich selbst ebenso wie CHARMAZ zuordnet. DENZIN (2007, S.454) wiederum nutzt sieben verschiedene Attribute, um unterschiedliche Debattenstränge der GTM-Diskussion zu identifizieren: "positivist, postpositivist, constructivist, objectivist, postmodern, situational, and computer assisted". "Die" GTM ist insofern ein problematischer Adressat. <zurück>

16) Zur von Forschenden generierten Datenspur bestehend aus Feldnotizen, Memos und weiteren Dokumenten vgl. RODGERS und COWLES (1993). <zurück>

17) Überlegungen zur Disparität zwischen idealer Forscher(innen)position und tatsächlicher Forschungssituation (insb. hinsichtlich Ressourcen, Flexibilität der Fragestellung und Schwierigkeiten im Feldzugang) werden auch von CHARMAZ (2006) angestellt. BREUER (1999) weist darauf hin, dass ein vollständiges Theoretical Sampling häufig aufgrund von Restriktionen (Zeit- und Ressourcenknappheit) nicht erreicht werde, weshalb das Ergebnis weniger als Theorie, sondern eher als Theorie-Skizze bezeichnet werden solle. DEY (1999) geht davon aus, dass lediglich eine Hinlänglichkeit der theoretischen Erklärung, aber keine den Gegenstand erschöpfende theoretische Saturierung als Ziel gelten dürfe (vgl. auch KRÜGER & MEYER 2007). <zurück>

18) Im Verlauf der Arbeiten zeigte sich allerdings, dass der Zugang zu einigen Informationen nicht erschlossen werden konnte; beispielsweise kamen Interviews mit der Polizei nicht zustande. <zurück>

19) Ein strukturell ähnliches Problem berichten DRAUCKER et al. (2007) als Verletzung der Grundprinzipien des Theoretical Sampling, wenn sich den Forschenden die Gelegenheit bietet beziehungsweise die Notwendigkeit ergibt, mehr Daten zu erheben als für den ersten Schritt der Konzeptualisierung benötigt werden. <zurück>

20) Während sich die ersten Gespräche mit Bewohner(inne)n aufgrund des geringen Vorwissens der Forschenden an den eroepischen Gesprächen nach GIRTLER (2001) orientierten, wurde die Gesprächsführung mit zunehmendem Kenntnisstand fokussierter und richtete sich zunehmend am problemzentrierten Interview nach WITZEL (2000) aus. <zurück>

21) Zu entsprechenden Forschungsergebnissen vgl. DIMBATH, ERNST-HEIDENREICH und ROCHE (2018). <zurück>

22) Bemerkenswert ist auch hier, dass im Vergleich zur Debatte über Theoretical Sampling die methodologischen Überlegungen zur Praxis des Kodierens weiter fortgeschritten sind, wie sich z.B. GLASERs Unterscheidung von Kodierfamilien entnehmen lässt (vgl. hierzu Übersicht 2 bei MEY & MRUCK 2011, S.37). Ähnliche Typisierungen sind auch mit Blick auf Theoretical Sampling möglich und im Grunde auch notwendig. <zurück>

23) Die Rede von maximaler und minimaler Kontrastierung legt zweipolige Entscheidungsmöglichkeiten nahe. Aber nicht immer basiert die Fallauswahl auf dichotomen Gegensatzpaaren. Über die Zeit können komplexere Klassifikationen, Subkategorisierungen oder gar mehrpolige Typologien als heuristische Grundlage für Fallauswahlentscheidungen entstehen. Doch selbst wenn die Theoriearbeit noch am Anfang steht, können Fallauswahlentscheidungen gleichzeitig entlang mehrerer Achsen vorgenommen werden. Immer aber geht es um die Frage, was jetzt warum auf welche Weise untersucht wird und was nicht. Dahingehend ist jede Entscheidung quasi-dichotom, wobei die Entscheidung für eine Auswahl immer konkret ist, die Entscheidung gegen alle anderen Optionen demgegenüber in den Hintergrund tritt und vergessen wird. <zurück>

24) STRAUSS (1998 [1987]) verweist bei solchen Fragen auf das Verfassen von Memos im weitesten Sinn. Die hier vorgeschlagenen Verlaufskarten systematisieren die Reflexion von Fallauswahlentscheidungen auf Dauer und integrieren sie als festen Bestandteil im Forschungsprozess. In der Terminologie der GTM geht es um systematische Memos zur Fallauswahl. Die gesonderte Akzentuierung von Fallauswahlmemos entbindet selbstredend nicht von der Notwendigkeit auch andere Typen von Memos anzufertigen. <zurück>

25) Bereits DRAUCKER et al. (2007) haben auf die praktische Bedeutung eines Dokumentationstools hingewiesen. Sie entwickeln einen "Theoretical Sampling Guide" welcher die jeweiligen Auswahlstrategien offenlegt, die Konzeptarbeit im Vergleich zu den Operatoren des Auswählens aber vernachlässigt. Im Gegensatz dazu haben wir mit der Verlaufskarte vor allem die Konzeptbildung und die Entwicklung von Kategorien im Blick. Erst vor dem Hintergrund einer eigens erarbeiteten, theoretischen Sensibilität erlangt die Entscheidung für unterschiedliche Selektionsoperatoren ihre Bedeutung. Die im "Theoretical Sampling Guide" angelegte sukzessive Trichterung ist sicherlich hilfreich. Dass es sich hier indes um methodisch distinkte Phasen handelt, bezweifeln wir. Zur Erörterung möglicher Selektionsstrategien siehe die Ausführungen von PATTON (1990); zur Diskussion von Kombinationsmöglichkeiten dieser Strategien und einem mehrstufigen Theoretical Sampling siehe DRAUCKER et al. (2007, S.1142f.). <zurück>

26) Hier sind auch mehrere Ausprägungen möglich; dichotome Paare schienen uns allerdings zum einen naheliegend für die empirisch vorgefundenen Kategorien, zum anderen erlaubten sie eine einfache Orientierung im Sinne einer minimalen/maximalen Kontrastierung bei der weiteren Fallauswahl. <zurück>

27) Vgl. hierzu die äquivalente Diskussion der Frage "Wer soll kodieren?" bei STRAUSS (1998 [1987], S.68f.). <zurück>

28) Eine solche Sichtweise wird insbesondere in den Arbeiten GLASERs, aber auch bei GLASER und STRAUSS (1967, S.61ff.) nahegelegt – und unter anderem von Kathy C. CHARMAZ als positivistisch kritisiert. Mit ihr folgen wir eher einer konstruktivistischen Lesart (vgl. z.B. CHARMAZ & PUDDEPHATT 2011), welche die eigene Analyse sozialer Phänomene als Konstruktionsarbeit "in a self-critical way" (CHARMAZ & KELLER 2016, §45) reflektiert. <zurück>

29) Solches wird beispielsweise von CORBIN und STRAUSS (1990) oder STRÜBING (2014) angeregt. Um die Angemessenheit von Forschung zu bewerten, schlagen CORBIN und STRAUSS (1990, S.17) bzgl. des Theoretical Sampling folgende Fragen als Kriterien vor: "On the basis of what categories did theoretical sampling proceed? That is, how did theoretical formulations guide some of the data collection? After the theoretical sample was carried out, how representative did these categories prove to be?" Nicht zuletzt zur forschungspraktischen Erfüllung bzw. Reflexion solcher Kriterien bieten Verlaufskarten eine mögliche verfahrensseitige Hilfestellung. <zurück>

Breckenridge, Jenna & Jones, Derek (2009). Demystifying theoretical sampling in grounded theory research. The Grounded Theory Review, 8(2), 113-126, http://groundedtheoryreview.com/wp-content/uploads/2012/06/GT-Review-Vol8-no2.pdf [Zugriff: 1. August 2018].

Breuer, Franz (1999). Einleitung. In Franz Breuer (Hrsg.), Abseits!? Marginale Personen – Prekäre Identitäten (S.3-6). Münster: Lit.

Bryant, Antony (2009). Grounded theory and pragmatism: The curious case of Anselm Strauss. Forum Qualitative Sozialforschung / Forum: Qualitative Social Research, 10(3), Art. 2, http://dx.doi.org/10.17169/fqs-10.3.1358 [Zugriff: 6. August 2018].

Charmaz, Kathy C. (2006). Constructing grounded theory. London: Sage.

Charmaz, Kathy C. & Keller, Reiner (2016). A personal journey with grounded theory methodology. Kathy Charmaz in conversation with Reiner Keller. Forum Qualitative Sozialforschung / Forum: Qualitative Social Research, 17(1), Art. 16, http://dx.doi.org/10.17169/fqs-17.1.2541 [Zugriff: 6. August 2018].

Charmaz, Kathy C. & Puddephatt, Anthony J. (2011). Grounded Theory konstruieren. In Katja Mruck & Günter Mey (Hrsg.), Grounded Theory Reader (2. Aufl., S.89-107). Wiesbaden: VS Verlag für Sozialwissenschaften.

Clarke, Adele E. (2005). Situational analysis: Grounded theory after the postmodern turn. Thousand Oaks, CA: Sage.

Corbin, Juliet M. & Strauss, Anselm L. (1990). Grounded theory research: Procedures, canons, and evaluative criteria. Qualitative Sociology, 13(1), 3-21.

Coyne, Imelda T. (1997). Sampling in qualitative research. Purposeful and theoretical sampling; merging or clear boundaries?. Journal of Advanced Nursing, 26(3), 623-630.

Denzin, Norman K. (2007). Grounded theory and the politics of interpretation. In Antony Bryant & Kathy C. Charmaz (Hrsg.), The SAGE handbook of grounded theory (S.454-471). Los Angeles, CA: Sage.

Dey, Ian (1999). Grounding grounded theory: Guidelines for qualitative inquiry. San Diego, CA: Academic Press.

Dimbath, Oliver; Ernst-Heidenreich, Michael & Roche, Matthias (2018). "Hinten ist Beverly Hills und hier ist einfach Ghetto, The Bronx." Grounded Theory im Kontext der narrativen Strukturierung eines Sozialraums. In Jeannine Wintzer (Hrsg.), Sozialraum erforschen: Qualitative Methoden in der Geographie (51-68). Wiesbaden: Springer Spektrum.

Draucker, Claire B.; Martsolf, Donna S.; Ross, Ratchneewan & Rusk, Thomas B. (2007). Theoretical sampling and category development in grounded theory. Qualitative Health Research, 17(8), 1137-1148.

Eisenhardt, Kathleen M. (1989). Building theories from case study research. Academy of Management Review, 14(4), 532-550.

Girtler, Roland (2001). Methoden der Feldforschung. Wien: Böhlau Verlag.

Glaser, Barney G. (1965). The constant comparative method of qualitative analysis. Social Problems, 12(4), 436-445.

Glaser, Barney G. (1978). Theoretical sensitivity: Advances in the methodology of grounded theory. Mill Valley, CA: Sociology Press.

Glaser, Barney G. (1992). Basics of grounded theory analysis: Emergence vs. forcing. Mill Valley, CA: Sociology Press.

Glaser, Barney G. (2001). The grounded theory perspective: Conceptualization contrasted with description. Mill Valley, CA: Sociology Press.

Glaser, Barney G. (2002). Conceptualization: On theory and theorizing using grounded theory. International Journal of Qualitative Methods, 1(2), 23-38, https://doi.org/10.1177/160940690200100203 [Zugriff: 4. August 2018].

Glaser, Barney G. & Holton, Judith A. (2004). Remodeling grounded theory. Forum Qualitative Sozialforschung / Forum: Qualitative Social Research, 5(2), Art. 4, http://dx.doi.org/10.17169/fqs-5.2.607 [Zugriff: 10. November 2017].

Glaser, Barney G. & Strauss, Anselm L. (1967). The discovery of grounded theory: Strategies for qualitative research. New Brunswick: Aldine.

Glaser, Barney G. & Strauss, Anselm L. (1970). Theoretical sampling. In Norman K. Denzin (Hrsg.), Sociological methods. A sourcebook (S.105-114). Chicago, IL: Aldine.

Guetterman, Timothy C. (2015). Descriptions of sampling practices within five approaches to qualitative research in education and the health sciences. Forum Qualitative Sozialforschung / Forum: Qualitative Social Research, 16(2), Art. 25, http://dx.doi.org/10.17169/fqs-16.2.2290 [Zugriff: 6. August 2018].

Hammersley, Martyn (2006). Theoretical sampling. In Victor Jupp (Hrsg.), The Sage dictionary of social research methods (S.298-299). London: Sage.

Holton, Judith A. (2007). The coding process and its challenges. In Anthony Bryant & Kathy C. Charmaz (Hrsg.), The SAGE handbook of grounded theory (S.265-290). Los Angeles, CA: Sage.

Kelle, Udo & Kluge, Susann (2010). Vom Einzelfall zum Typus: Fallvergleich und Fallkontrastierung in der Qualitativen Sozialforschung (2. Aufl.). Wiesbaden: VS Verlag für Sozialwissenschaften.

Keller, Reiner (2012). Das interpretative Paradigma. Eine Einführung. Wiesbaden: Springer VS.

Kluge, Susann (1999). Empirisch begründete Typenbildung. Zur Konstruktion von Typen und Typologien in der qualitativen Sozialforschung. Opladen: Leske + Budrich.

Krüger, Paula & Meyer, Imke K. (2007). Eine Reise durch die Grounded Theory. Review Essay: Kathy Charmaz (2006). Constructing Grounded Theory. A Practical Guide Through Qualitative Analysis. Forum Qualitative Sozialforschung / Forum: Qualitative Social Research, 8(1), Art. 25, http://dx.doi.org/10.17169/fqs-8.1.226 [Zugriff: 31. Juli 2018].

Lakatos, Imre (1982). Die Methodologie der wissenschaftlichen Forschungsprogramme. Braunschweig: Vieweg.

Lamnek, Siegfried (2005). Qualitative Sozialforschung (4. Aufl.). Weinheim: Beltz.

Lindemann, Gesa (2008). Theoriekonstruktion und empirische Forschung. In Herbert Kalthoff, Stefan Hirschauer & Gesa Lindemann (Hrsg), Theoretische Empirie: Zur Relevanz qualitativer Forschung (S.107-128). Frankfurt/M.: Suhrkamp.

Mason, Mark (2010). Sample size and saturation in PhD studies using qualitative interviews. Forum Qualitative Sozialforschung / Forum: Qualitative Social Research, 11(3), Art. 8, http://dx.doi.org/10.17169/fqs-11.3.1428 [Zugriff: 6. August 2018].

Mey, Günter & Mruck, Katja (2011). Grounded Theory Methodologie: Entwicklung, Stand, Perspektiven. In Günter Mey & Katja Mruck (Hrsg.), Grounded Theory Reader (2. Aufl., S.11-48). Wiesbaden: VS Verlag für Sozialwissenschaften.

Mruck, Katja & Mey, Günter (2019/Im Erscheinen). Grounded theory methodology and self-reflexivity in the qualitative research process. In Anthony Bryant & Kathy C. Charmaz (Hrsg.), The SAGE handbook of current developments in grounded theory (2. Aufl.). London: Sage.

Morse, Janice M. (2007). Sampling in grounded theory. In Anthony Bryant & Kathy C. Charmaz (Hrsg.), The Sage handbook of grounded theory (S.229-244). Los Angeles, CA: Sage.

Muckel, Petra (2011). Die Entwicklung von Kategorien mit der Methode der Grounded Theory. In Günter Mey & Katja Mruck (Hrsg.), Grounded Theory Reader (2. Aufl., S.333-352). Wiesbaden: VS Verlag für Sozialwissenschaften.

Patton, Michael Q. (1990). Qualitative evaluation and research methods (2. Aufl.). Newbury Park, CA: Sage.

Rodgers, Beth L. & Cowles, Kathleen V. (1993). The qualitative research audit trail: A complex collection documentation. Research in Nursing & Health, 16(3), 219-226.

Stratkötter, Andreas (1996). Erfahrungen mit dem Theoretical Sampling. In Franz Breuer (Hrsg.), Qualitative Psychologie. Grundlagen, Methoden und Anwendungen eines Forschungsstils (S.95-98). Opladen: Westdeutscher Verlag.

Strauss, Anselm L. (1998 [1987]). Grundlagen qualitativer Sozialforschung: Datenanalyse und Theoriebildung in der empirischen und soziologischen Forschung. München: Fink.

Strauss, Anselm L. & Corbin, Juliet M. (1998 [1990]). Basics of qualitative research: Techniques and procedures for developing Grounded theory (2. Aufl.). Thousand Oaks, CA: Sage.

Strübing, Jörg (2008). Pragmatismus als epistemische Praxis. Der Beitrag der Grounded Theory zur Empirie-Theorie-Frage. In Herbert Kalthoff, Stefan Hirschauer & Gesa Lindemann (Hrsg.), Theoretische Empirie. Zur Relevanz qualitativer Forschung (S.279-311). Frankfurt/M.: Suhrkamp.